论文背景

这篇是讲slot filling和intent detection的联合训练。传统的方法slot filling和intent detection是分开做的,会出现error propagation的问题。

所以现代一点的方法主要有下面几种:

joint attention-based rnn (2016)

rnn-lstm (2016)

slot-gated model (2018)

这篇文章同样认同两个任务之间的相关性并且提出SF-ID网络。

模型结构

Integration of context

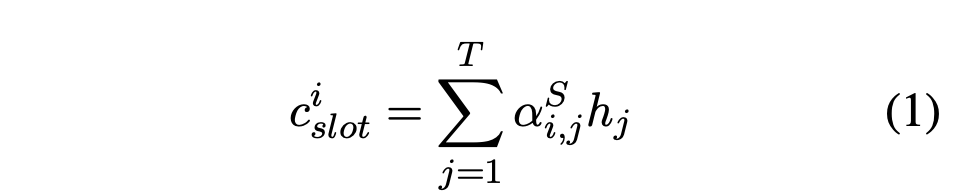

slot filling:

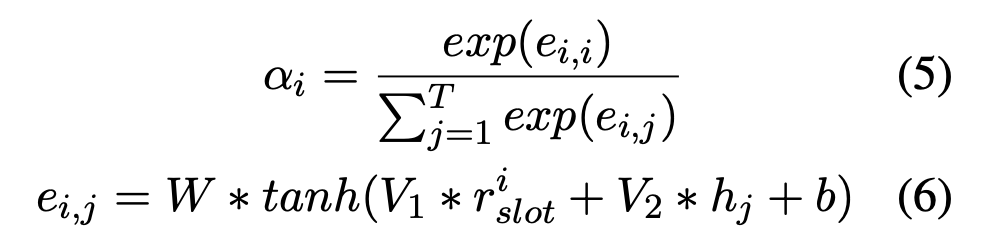

然后这篇加权的方法和16年那篇一样,是用encoder和decoder一起生成context向量并且最后喂给encoder端的hidden_state进行加权表示,具体可以看16年那篇文章。

intent detection:

similar to slot filling

SF-ID Network

SF-ID Network有SF-First和ID-First两种形式。下面就说其中一种SF-first,另外一种只是把subnet的先后顺序互换而已。

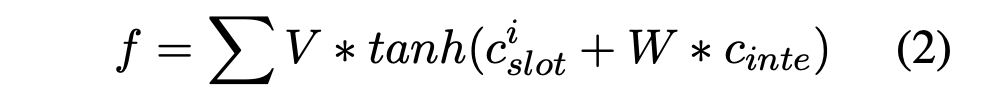

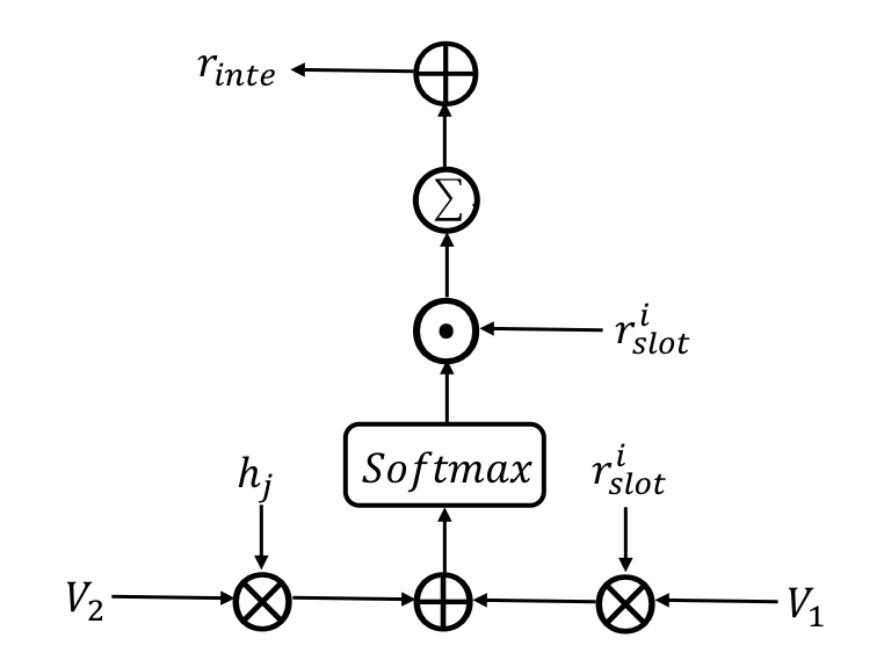

SF subnet

ID subnet

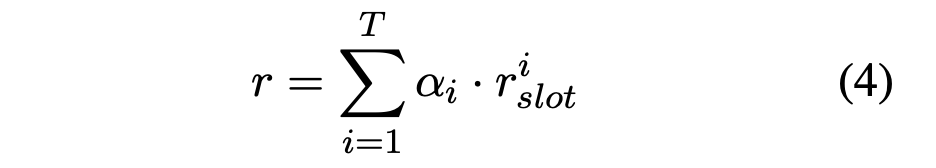

Iteration Mechanism

向量表示的交互和耦合把context对应的向量换成reinforce对应的向量,最后输出softmax分类。

CRF layer

添加转移概率增加label预测的约束和鲁棒性,就比较常规。

Experiment

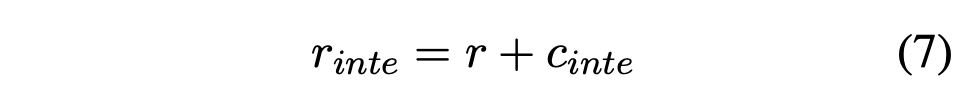

其中有2个比较有意思的分析:

Analysis of Model mode:

ID-First mode的实验结果在slot filling上更好, SF-First mode的实验结果在intent detection上的效果更好。说白了,哪个先训练就定了整个模型的任务倾向性基调。

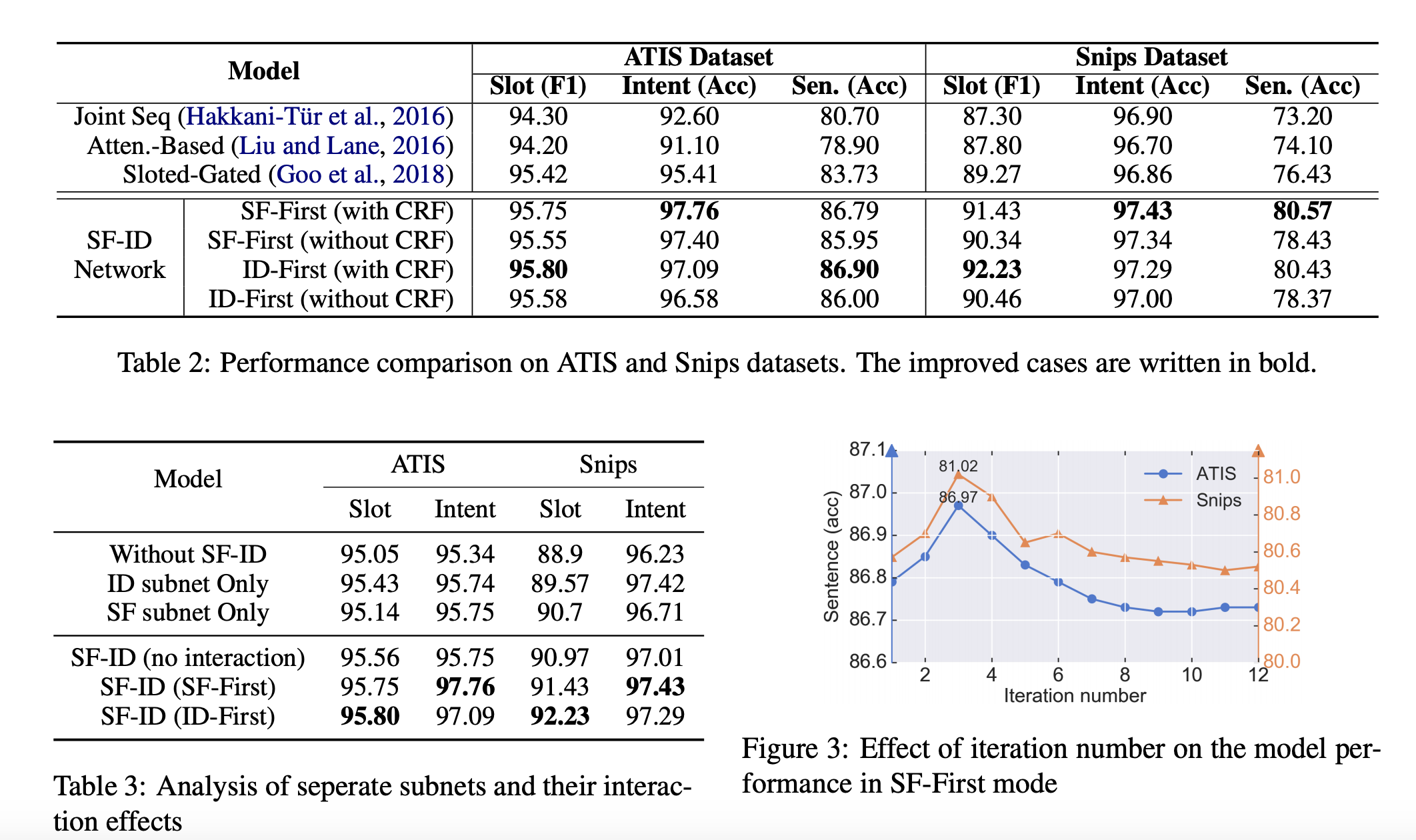

Iteration Mechanism:

一定的iteration迭代能够提高训练的效果,但是迭代的次数越多反而就不好了。